robots文件存在于网站根目录,是用来告诉百度蜘蛛那些应该抓取,那些不应该抓取。正确使用robots文件有助于做好seo优化,robots文件的核心词汇就是allow和disallow用法。百度官网是认可这个文件的,在百度站长平台上也有robots这个栏目,点击进入,就可以看到你网站robots文件是否编写正确了。

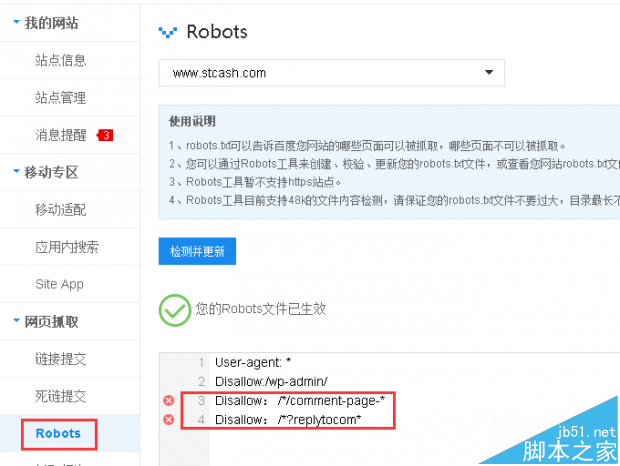

百度robots文件使用说明

1、robots.txt可以告诉百度您网站的哪些页面可以被抓取,哪些页面不可以被抓取。

2、您可以通过Robots工具来创建、校验、更新您的robots.txt文件,或查看您网站robots.txt文件在百度生效的情况。

3、Robots工具暂不支持https站点。

4、Robots工具目前支持48k的文件内容检测,请保证您的robots.txt文件不要过大,目录最长不超过250个字符。

上图我给的一个例子中,disallow语句有问题,原因是把英文的冒号写成了中文的冒号。

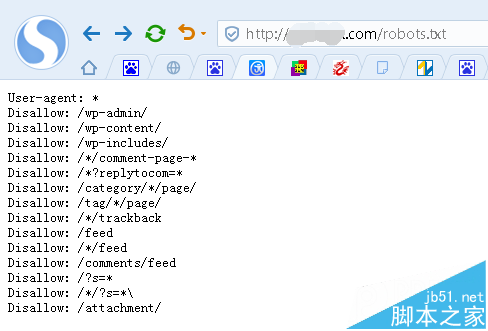

当然直接输入网站根目录加上robtots.txt文件也可以

User-agent:* 是用来置顶那些搜索引擎蜘蛛可以抓取的,一般默认设置

Disallow:/category/*/page/ 分类目录下面翻页后的链接,比如,进入校赚网分类目录 "推广运营经验"目录后,在翻页一次,就成了 stcash.com/category/tuiguangyunying/page/2形式了

Disallow:/?s=* Disallow:/*/?s=* 搜索结果页面和分类目录搜索结果页面,这里没必要再次抓取。

Disallow:/wp-admin/ Disallow:/wp-content/ Disallow:/wp-includes/ 这三个目录是系统目录,一般都是屏蔽蜘蛛抓取

Disallow:/*/trackback trackback的链接

Disallow:/feed Disallow:/*/feed Disallow:/comments/feed 订阅链接

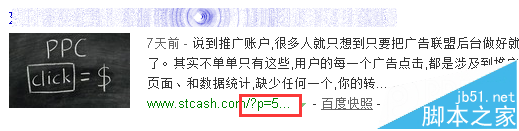

Disallow:/?p=* 文章短链接,会自动301跳转到长连接

例如,朱海涛博客之前就被收录过短连接

Disallow:/*/comment-page-* Disallow:/*?replytocom* 这两个我在之前文章有过说明,来自于评论链接,很容易造成重复收录。

在robots.txt文件的最后还可以制定sitemap文件 Sitemap:http://***.com/sitemap.txt

sitemap地址指令,主流是txt和xml格式。在这里分享一段张戈所写txt格式的simemap文件。

将上述代码保存到txt文件,上传到根目录,并且在robots.txt文件中指定即可

这里给大家共享下我的robots.txt文件